- Data Analytics

- Visual Design

Wir haben ein innovatives 3D-Datenvisualisierungs- und Simulationsframework entwickelt, das generative Modellierung, Echtzeit-Simulation und GPU-gestützte Analyse kombiniert. Dieses ganzheitliche System ermöglicht es, komplexe Daten nicht nur zu visualisieren, sondern auch dynamisch zu analysieren und in bestehende Data-Pipelines zu integrieren. Für diese wissenschaftlich-technische Innovationskompetenz hat M2 das BSFZ-Siegel erhalten.

Artikel von Christoph Maurer, Data Science & AI und Visual Design Lead bei M2

Als Data-Analytics- und Consulting-Unternehmen mit einem starken Fokus auf Business Intelligence sehen wir unsere Mission darin, komplexe Daten nicht nur aufzubereiten, sondern in einer Form zu präsentieren, die den größtmöglichen Mehrwert schafft. Seit Jahren integrieren wir BI-Lösungen in Unternehmen unterschiedlichster Branchen und haben dabei gemerkt: Viele Herausforderungen rund um Prozessoptimierung oder die Simulation von Abläufen und Szenarien benötigen heute mehr als „klassische“ 2D-Datenvisualisierungen.

Vor drei Jahren haben wir deshalb ein ambitioniertes Forschungsprojekt gestartet. Das Ziel: Ein umfassendes Framework zu entwickeln, das generative und analytische 3D-Datenvisualisierung und Simulation neu definiert und nahtlos in bestehende Data-Pipelines eingebunden werden kann.

Die Innovation dahinter wurde nun von offizieller Seite gewürdigt: Wir haben für unser dreijähriges Forschungsvorhaben das BSFZ-Siegel nach dem Forschungszulagengesetz (FZulG) erhalten. Die Bescheinigungsstelle Forschungszulage (BSFZ) hat unser Projekt geprüft und die wissenschaftlich-technische Neuartigkeit bestätigt Dieses Siegel bestätigt uns die wissenschaftlich-technische Neuartigkeit und unterstreicht, dass wir hier einen echten Meilenstein in der 3D-Datenaufbereitung setzen.

1. Generative 3D-Strukturen & hochperformante Simulation

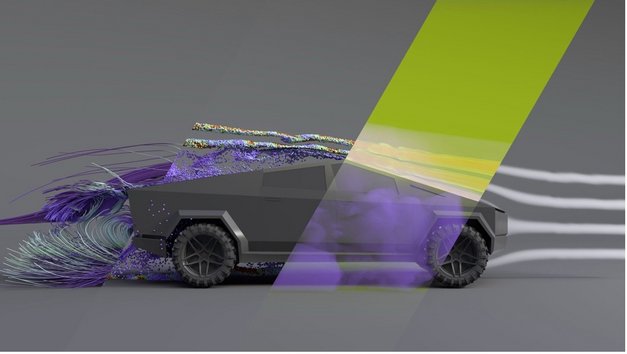

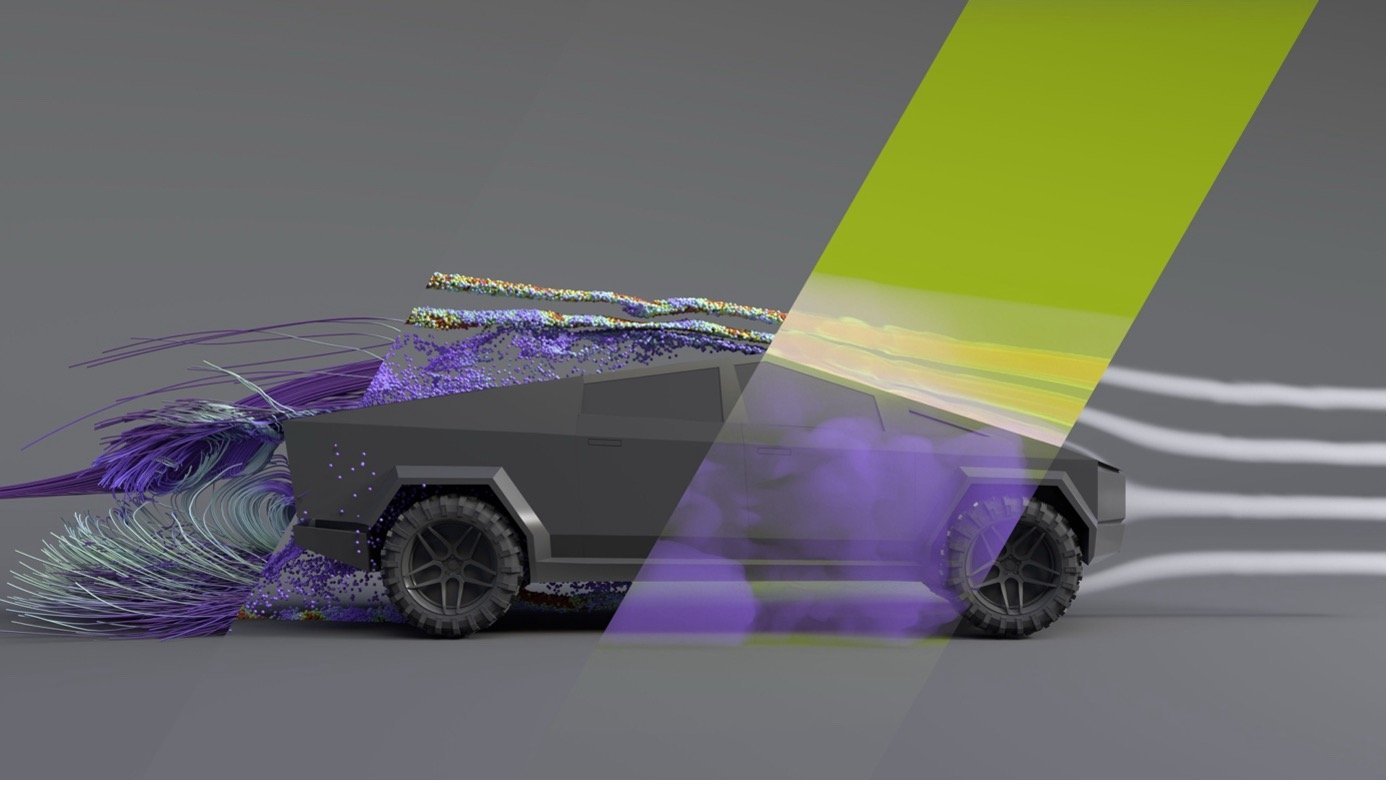

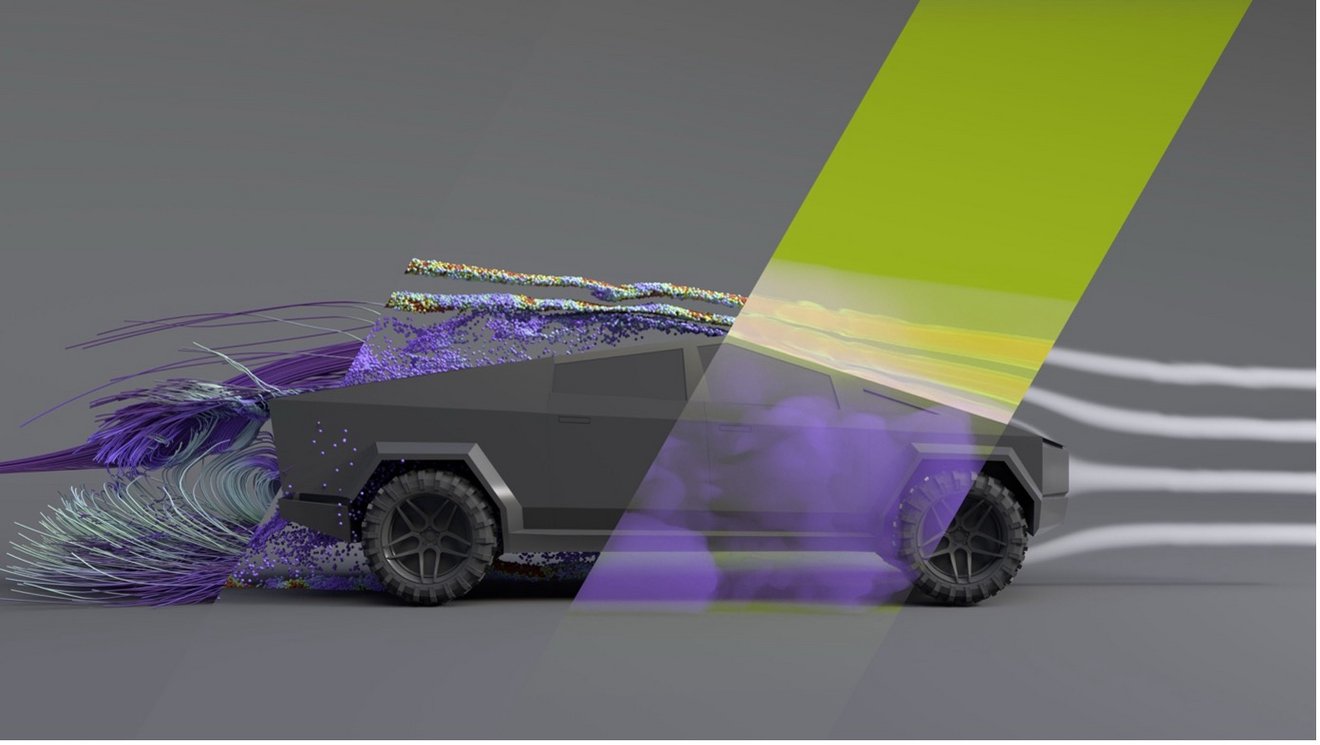

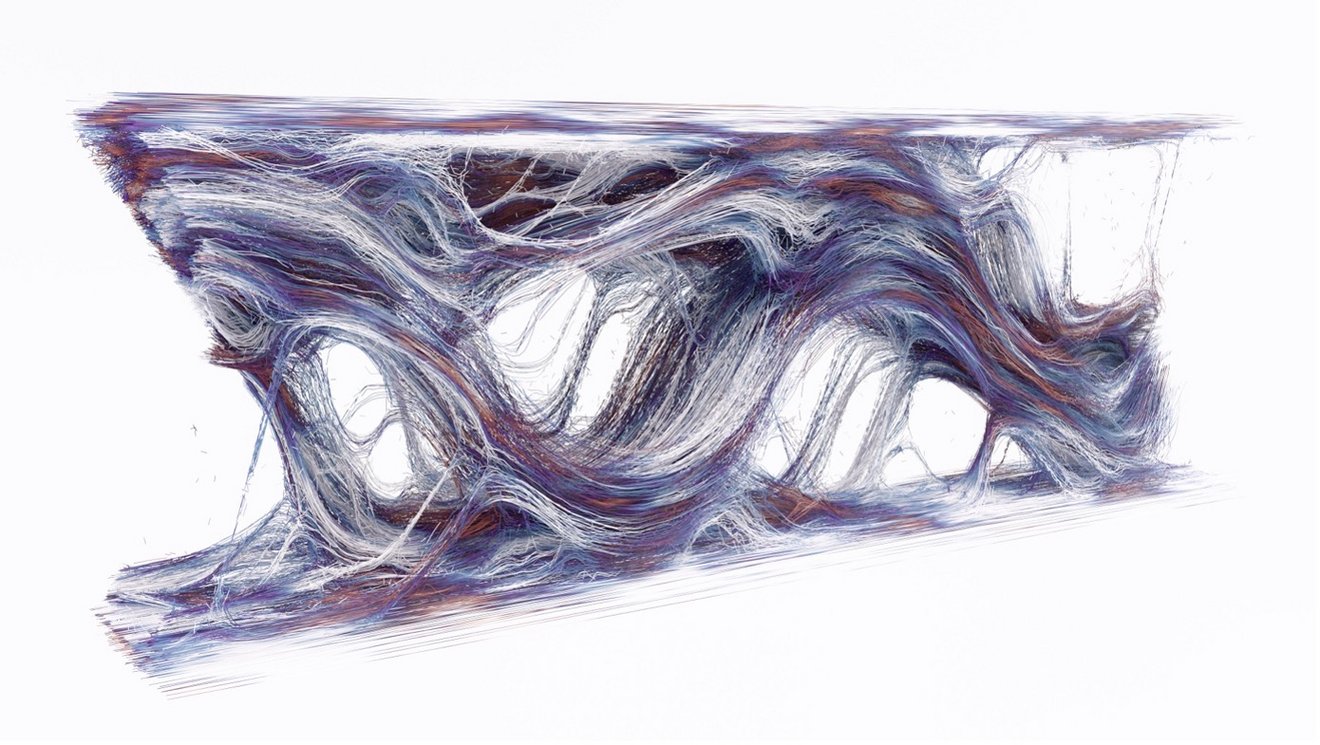

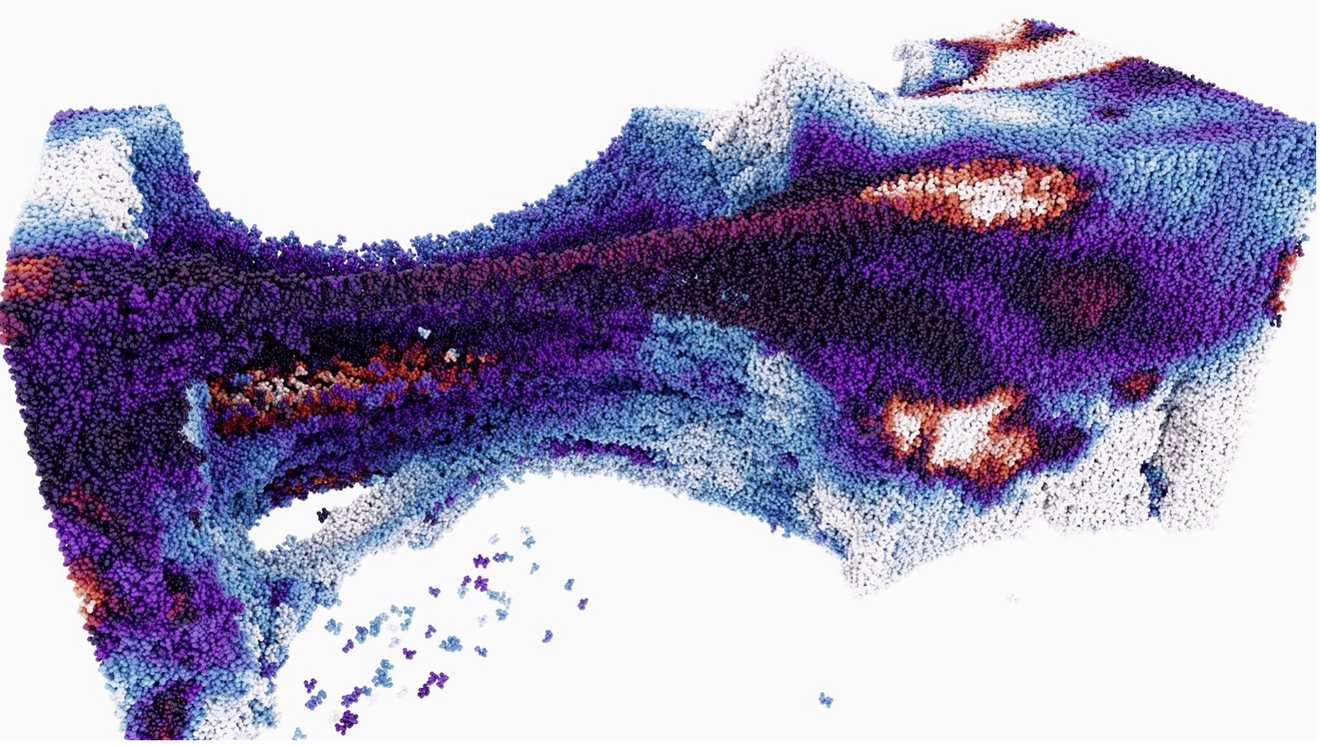

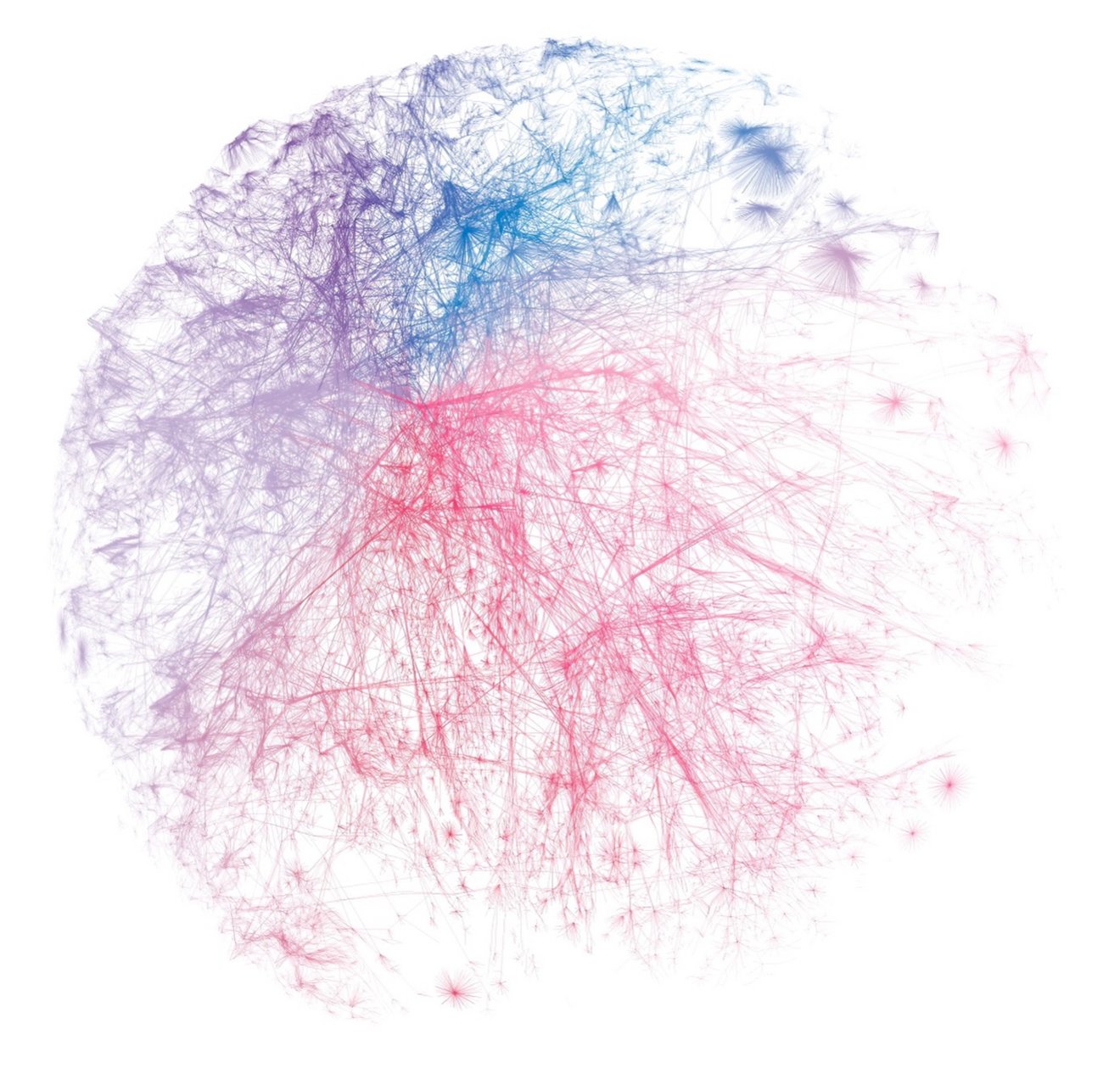

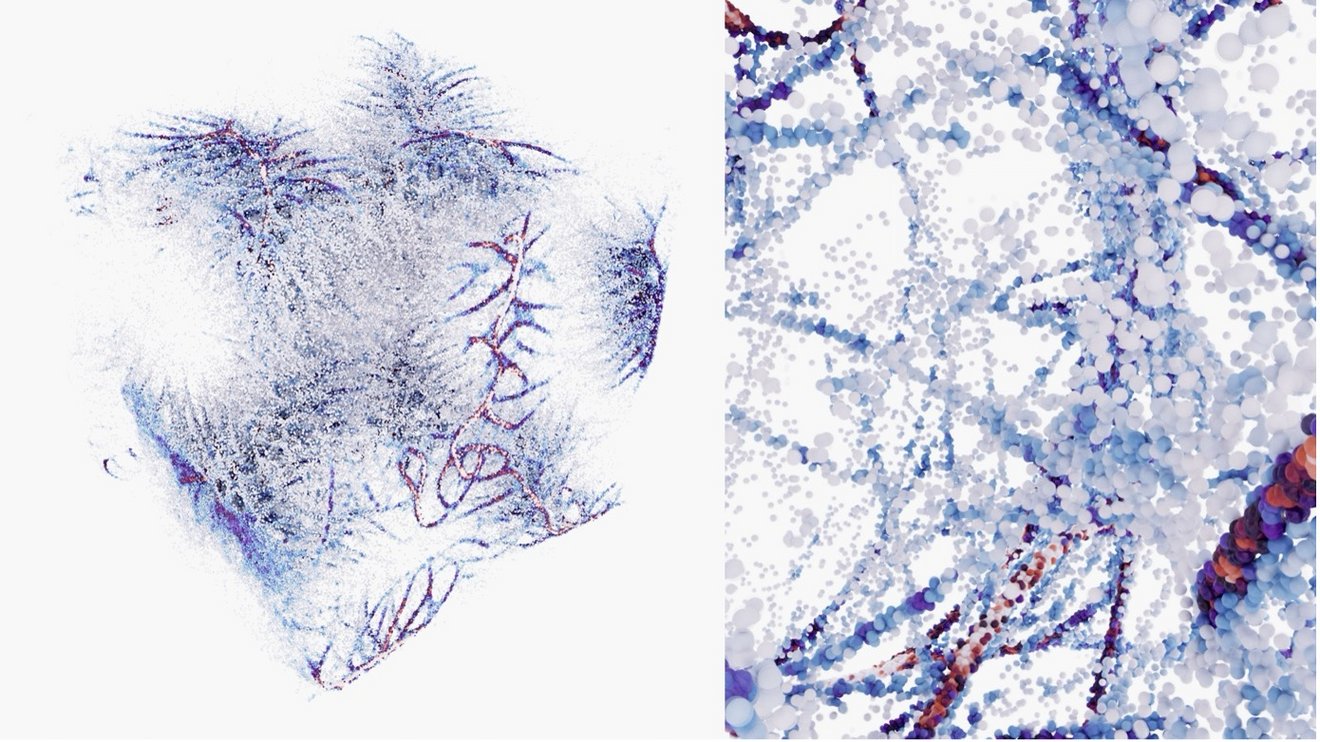

Wir haben einen prozeduralen Ansatz gewählt, der alle Arbeitsschritte vom Daten-ETL-Prozess über die generative Modellerstellung bis hin zu verschiedensten Simulationsarten vereint. Dadurch lässt sich nahezu jede Art von 3D-Objekt erstellen, analysieren und in Echtzeit anpassen: Differentielle und prozedurale Generierung (z.B.: Reaktions-Diffusion, Differential Growth), Particle- und Fluid-Simulation, Festkörperberechnungen und Netzwerk-Algorithmen (Force-Directed Graphs).

Diese Module sind teils GPU-beschleunigt, um bei großen Datenmengen die nötige Performance und Skalierbarkeit zu liefern.

2. Analytische Verfahren nahtlos integriert

Statt reiner 3D-Grafik „auf Verdacht“ anwenden zu müssen, setzen wir systematische Analysen ein. Mittels Python-Bibliotheken wie cuDF und cuML (GPU-basiert) können große Datenmengen effizient verarbeitet und direkt in unsere 3D-Pipelines integriert werden. Clustering-Verfahren (z. B. DBSCAN, HDBSCAN oder K-Means) schaffen die Grundlage für fundierte Erkenntnisse in Echtzeit.

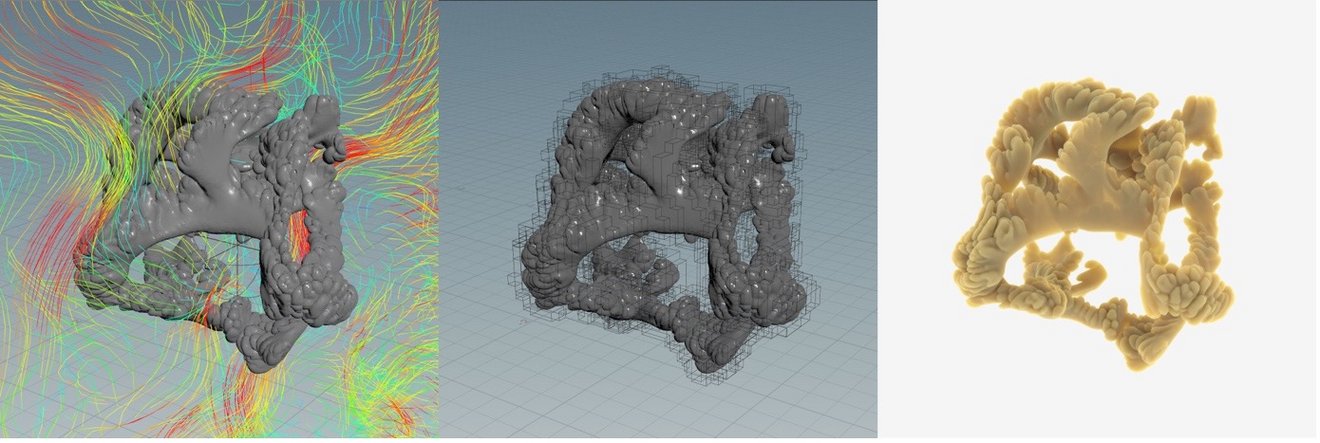

3. High-End-Visualisierung in Houdini & Omniverse

Unser Entwicklungs-Stack verknüpft die Flexibilität von SideFX Houdini – bekannt für seine prozeduralen Workflows – mit der mächtigen NVIDIA Omniverse-Plattform, die Echtzeit-Raytracing und physikalisch korrekte Simulation auf Multi-GPU-Hardware ermöglicht. Das Bindeglied: USD (Universal Scene Description). Mit USD speichern wir sämtliche Assets und Simulationsdaten in nicht-destruktiver Form, was auch Kollaboration und wiederholte Iterationen um ein Vielfaches vereinfacht.

4. Fokus auf Cloud- und GPU-Performance

Die Cloudfähigkeit von Omniverse, kombiniert mit unserer modularen Architektur, erschließt völlig neue Anwendungsfelder. So können wir riesige Datenströme oder umfangreiche Simulationen in kürzester Zeit ausführen und visualisieren – ob für Industrial Metaverse, Digital Twins, Robotik-Training oder wissenschaftliche Forschung.

• Ganzheitlicher Workflow: Statt Insellösungen für Datenbereinigung, Simulation und Visualisierung zu nutzen, integriert unser Framework alle Prozessschritte in einer Pipeline.

• Hohe Performance & Skalierbarkeit: Durch GPU-Beschleunigung in jedem Schritt und spezialisierte Implementierungen in VEX, OpenCL oder CUDA erzielen wir auch bei sehr großen Datensätzen eine hohe Rechengeschwindigkeit.

• Universelles Speicherformat: Mit USD haben wie eine zentrale Datendrehscheibe, um Metadaten, Varianten und komplexe 3D-Szenen effizient handhaben zu können.

• Erweiterbare Module: Wir entwickeln HDAs (Houdini Digital Assets) sowie Omniverse-Extensions, mit denen sich unsere Lösungen flexibel in bestehende Pipelines einbinden lassen.

Diese Eigenschaften wurden in der Fachwelt bislang nicht in dieser Kombination umgesetzt. Klassische Simulations-Tools sind meist monolithisch und nur CPU-basiert, während GPU-beschleunigte Module oft reine Spezialanwendungen sind. Die Zusammenführung in ein ganzheitliches, generatives und analytisches 3D-Daten-Framework ist ein entscheidender Schritt, um die Lücke zwischen Data Science und 3D-Visualisierung zu schließen.

Die Entwicklung eines solchen Frameworks bringt Herausforderungen mit sich, die wir in unzähligen Tests angegangen sind:

• GPU vs. CPU-Berechnungen:

Nicht jeder Algorithmus lässt sich effizient auf die GPU auslagern (Stichwort FP64-Genauigkeit). Durch umfassende Benchmark-Tests finden wir die Balance, wann ein Verfahren besser auf der CPU oder auf der GPU läuft.

• Interoperabilität verschiedener Simulationen:

Unterschiedliche Auflösungen bei Volumen, Polygonmeshes oder Partikelsystemen erfordern sorgfältige Parametrisierung und Datenaustauschprozesse. Wir haben einen mehrstufigen Validierungsprozess eingeführt, um sicherzustellen, dass die Simulationspipeline stabil und reproduzierbar ist.

• Datenmengen & Speicherlast:

Da wir über USD alle Schritte protokollieren und Varianten abspeichern können, steigt das Datenvolumen. Mit eigens entwickelten Import- und Export-Schnittstellen steuern wir sehr granular, welche Informationen wann und in welcher Auflösung ins USD-File geschrieben werden.

Gerade diese technischen und wissenschaftlichen Risiken machen den Forschungscharakter unseres Vorhabens aus – und sorgen dafür, dass wir am Ende ein robustes Produkt anbieten können.

Unsere 3D-Datenvisualisierung geht weit über bloße „Eye-Candy“-Darstellungen hinaus. Wir orientieren uns an einem layered approach, wie ihn die „Grammar of Graphics“ vorgibt, indem wir Visualisierungen in klar definierte Schichten (Daten, Transformationen, Geometrien, Skalen) aufteilen und erreichen damit konsistente Diagrammformen und präzisen Datenvermittlung.

Gleichzeitig verstehen wir Diagramme als aktive Werkzeuge, die implizites Wissen explizieren und Beziehungen sichtbar machen. Ihr Kern sind relationale Strukturen – in unserem Framework etwa durch Force-Directed Graphs und Netzwerkalgorithmen. Metaphern wie „Fluss“ oder „Raum“ erleichtern zudem das intuitive Begreifen abstrakter Größen. Diagramme können nicht nur den Ist-Zustand abbilden, sondern auch künftige Szenarien simulieren. Unser non-destruktiver Workflow macht Visualisierungen zu fortwährenden Experimentierfeldern und „Generators of Insight“.

Durch die Synthese aus Grammar of Graphics und Diagrammatik werden unsere 3D-Visualisierungen zu denkenden Werkzeugen, in denen Data Science und 3D-Darstellung so verschmelzen, dass neues Wissen relational, itterativ und skalierbar entsteht.

• Industrial Metaverse & Digital Twins:

Komplexe IoT-Datenströme lassen sich in Echtzeit in einer interaktiven 3D-Umgebung auswerten und simulieren.

• Robotik & Automatisierung:

KI-Trainingsdatensätze können in prozedural generierten 3D-Welten effizient erweitert werden – ein Quantensprung beim Sim-to-Real-Transfer.

• Wissenschaftliche Forschung & Education:

Großangelegte Simulationsprojekte (z. B. Strömungsmechanik, Astrophysik) können GPU-beschleunigt und kooperativ in der Cloud bearbeitet werden.

Unser Framework bleibt dabei modular erweiterbar – wir arbeiten bereits an neuen Komponenten für KI-gestütztes Rendering, Physics-Informed Neural Networking (PINN) sowie AR- und VR-Integrationen.

Die Auszeichnung mit dem BSFZ-Siegel nach dem Forschungszulagengesetz bekräftigt nicht nur die Innovationskraft unseres Projekts, sondern zeigt auch, welchen Nutzen ein solches Framework für verschiedenste Branchen und Forschungszweige haben kann. Die Arbeit endet hier keineswegs – wir sehen unsere Lösung als Startpunkt, um die Lücke zwischen klassischer Datenanalyse und fortschrittlicher 3D-Simulation zu schließen.

Wir freuen uns darauf, Unternehmen und Forschungseinrichtungen gleichermaßen mit unserem Framework zu unterstützen. Denn wer heute komplexe Fragestellungen bearbeitet – sei es in Industrie 4.0, Digital Twins oder wissenschaftlichen Modellsimulationen – braucht einen ganzheitlichen, performanten Ansatz. Genau den stellen wir Ihnen zur Verfügung.

Wenn Sie mehr erfahren wollen oder Ihre Projekte mit unserem Framework beschleunigen möchten, melden Sie sich gerne. Gemeinsam gestalten wir die Zukunft der 3D-Datenwelt!